AlphaGo是什么 谷歌AlphaGo詳細(xì)介紹 基礎(chǔ)由神經(jīng)網(wǎng)絡(luò)系統(tǒng)構(gòu)成 專為下圍棋而開發(fā)

谷歌AlphaGo是什么?作為一種人工智能的AlphaGo,和IBM 在上個世紀(jì)打敗國際象棋大師卡斯帕羅夫的深藍(lán)超級計算機(jī),以及當(dāng)代的蘋果Siri、Google Now有著顯著的區(qū)別。要解讀AlphaGo,首先我們需要了解AlphaGo背后到底是一個什么東西。

(資料圖片僅供參考)

(資料圖片僅供參考)

其實谷歌AlphaGo背后是一套神經(jīng)網(wǎng)絡(luò)系統(tǒng),由 Google 2014 年收購的英國人工智能公司 DeepMind 開發(fā)。這個系統(tǒng)和深藍(lán)不同,不是一臺超級計算機(jī),而是一個由許多個數(shù)據(jù)中心作為節(jié)點相連,每個節(jié)點內(nèi)有著多臺超級計算機(jī)的神經(jīng)網(wǎng)絡(luò)系統(tǒng)。 就像人腦,是由 50-100 億個神經(jīng)元所組成的,這也是為什么這種機(jī)器學(xué)習(xí)架構(gòu)被稱為神經(jīng)網(wǎng)絡(luò)。

你可以將AlphaGo 理解為《超驗駭客》(Transcendence) 里約翰尼·德普飾演的人工智能,而它所控制的超級計算機(jī),就像影片里被人工智能心控的人類一樣,共同為一種蜂群思維 (Hive Mind) 服務(wù)。

《超驗駭客》中,被人工智能控制的工人馬丁。馬丁沒有所想,但他的所見將會被人工智能直接獲取。

AlphaGo 是在這個神經(jīng)網(wǎng)絡(luò)系統(tǒng)上,專為下圍棋 (Go) 而開發(fā)出的一個實例。然而,雖然名字已經(jīng)介紹了它的功能,AlphaGo 背后的神經(jīng)網(wǎng)絡(luò)系統(tǒng)卻適合用于任何智力競技類項目。

這個系統(tǒng)的基礎(chǔ)名叫卷積神經(jīng)網(wǎng)絡(luò) (Convolutional Neural Network, CNN) ,這是一種過去在大型圖像處理上有著優(yōu)秀表現(xiàn)的神經(jīng)網(wǎng)絡(luò),經(jīng)常被用于人工智能圖像識別,比如 Google 的圖片搜索、百度的識圖功能都對卷積神經(jīng)網(wǎng)絡(luò)有所運用。這也解釋了為什么AlphaGo 是基于卷積神經(jīng)網(wǎng)絡(luò)的,畢竟圍棋里勝利的原理是:

對弈雙方在棋盤網(wǎng)格的交叉點上交替放置黑色和白色的棋子。落子完畢后,棋子不能移動。對弈過程中圍地吃子,以所圍“地”的大小決定勝負(fù)。

AlphaGo 背后的系統(tǒng)還借鑒了一種名為深度強(qiáng)化學(xué)習(xí) (Deep Q-Learning, DQN) 的技巧。強(qiáng)化學(xué)習(xí)的靈感來源于心理學(xué)中的行為主義理論,即有機(jī)體如何在環(huán)境給予的獎勵或懲罰的刺激下,逐步形成對刺激的預(yù)期,產(chǎn)生能獲得最大利益的習(xí)慣性行為。不僅如此,AlphaGo 借鑒了蒙特卡洛樹搜索算法 (Monte Carlo Tree Search) ,在判斷當(dāng)前局面的效用函數(shù) (value function) 和決定下一步的策略函數(shù) (policy function) 上有著非常好的表現(xiàn),遠(yuǎn)超過上一個能夠和人類棋手旗鼓相當(dāng)?shù)膰宄绦颉?/p>

DeepMind 訓(xùn)練AlphaGo 的步驟說明:10 萬盤高手棋譜作為初始數(shù)據(jù),進(jìn)行分類后用于訓(xùn)練策略函數(shù);然后跟自己下棋;強(qiáng)化學(xué)習(xí)訓(xùn)練策略函數(shù),繼續(xù)下棋;下了 3000 萬步后進(jìn)行回歸分析,整合蒙特卡洛樹搜索模型,訓(xùn)練效用函數(shù)。

效用函數(shù)和策略函數(shù),分別對應(yīng)AlphaGo 的兩個思考維度:目前棋盤的現(xiàn)狀,和自己/對手下一步的走向。

AlphaGo 所采用的 DQN 是一種具有廣泛適應(yīng)性的強(qiáng)化學(xué)習(xí)模型,說白了就是不用修改代碼,你讓它下圍棋它能下圍棋,你讓它在紅白機(jī)上玩超級瑪麗和太空侵略者,它也不會手生。作為一個基于卷積神經(jīng)網(wǎng)絡(luò)、采用了強(qiáng)化學(xué)習(xí)模型的人工智能,AlphaGo 的學(xué)習(xí)能力很強(qiáng),往往新上手一個項目,玩上幾局就能獲得比世界上最厲害的選手還強(qiáng)的實力。

2014 年,已經(jīng)被 Google 收購的 DeepMind,用五款雅達(dá)利 (Atari) 游戲 Pong、打磚塊、太空侵略者、海底救人、Beam Rider 分別測試了自己開發(fā)的人工智能的性能,結(jié)果發(fā)現(xiàn):在兩三盤游戲后,神經(jīng)網(wǎng)絡(luò)的操控能力已經(jīng)遠(yuǎn)超世界上任何一位已知的游戲高手。

DeepMind 用同樣的一套人工智能,不調(diào)整代碼就去測試各種各樣的智力競技項目,取得了優(yōu)異的戰(zhàn)績,足以證明今天坐在李世石面前的AlphaGo ,擁有多強(qiáng)的學(xué)習(xí)能力。

李世石執(zhí)黑子,AlphaGo 執(zhí)白子。大約進(jìn)行了 85 分鐘時進(jìn)入休息階段

在此之前,DeepMind 進(jìn)行過的無數(shù)虛擬棋局訓(xùn)練,以及去年擊敗歐洲圍棋冠軍樊麾二段的經(jīng)驗讓AlphaGo 已經(jīng)訓(xùn)練出了頂尖的弈技,極有可能高于世界上任何已知的圍棋高手。

AlphaGo 的水平大約在專業(yè)六段左右。再和其他圍棋程序的 495 盤較量中勝 494 盤;在讓 4 子的前提下仍有 75% 的勝率。

盡管棋盤上風(fēng)云變化,早在本次開戰(zhàn)前,AlphaGo 跟李世石就已不在同一起跑線上了。根據(jù) DeepMind 透露的情況,從去年 10 月 5-0 擊敗樊麾二段到現(xiàn)在,AlphaGo 已經(jīng)在神經(jīng)網(wǎng)絡(luò)容量(數(shù)據(jù)容量)以及自己跟自己下棋用于訓(xùn)練的數(shù)據(jù)質(zhì)量上有了較大的提升。而且神經(jīng)網(wǎng)絡(luò)的分布式計算延遲也得到了優(yōu)化,最終使得AlphaGo 能夠在兩小時的限定時間內(nèi)擊敗了李世石九段。

AlphaGo 只是 DeepMind 證明自己的一個工具。你也可以將這次和李世石的對局理解為 Google 的公關(guān)策略。

2014 年,這家公司曾經(jīng)在其官網(wǎng)上寫道: DeepMind 致力于用研究深度學(xué)習(xí)的方式去真正了解智慧 (solve intelligence) 。但對于 DeepMind 和 Google 來說,打造AlphaGo 以及其他人工智能神經(jīng)網(wǎng)絡(luò)不是終點

將機(jī)器學(xué)習(xí)和神經(jīng)科學(xué)進(jìn)行結(jié)合,打造出一種“一般用途的學(xué)習(xí)算法”。通過這種算法,DeepMind 和 Google 希望能夠?qū)⒅悄?ldquo;定型化”,理解智能是什么,進(jìn)而更好的幫助人類理解大腦。DeepMind 聯(lián)合創(chuàng)始人之一的 Demis Hassabis 曾經(jīng)寫道:

用算法將智慧提煉出來,有可能成為理解人類思維最神秘原理的最佳方式。

attempting to distil intelligence into an algorithmic construct may prove to be the best path to understanding some of the enduring mysteries of our minds.

在 Google 收購 DeepMind 前,收購條款中的一項就是 Google 必須成立人工智能道德委員會。因此,在目前階段人們不必?fù)?dān)心這樣的人工智能最終殺死或統(tǒng)治人類。但至少,人工智能在圍棋這樣的智力類競技項目上擊敗人類,是已經(jīng)注定的事情。

作為一種決策樹巨大的游戲,圍棋本來適合人腦思考,不適合機(jī)器運算。但 DeepMind AI 的方向就是模仿人腦思考,用神經(jīng)網(wǎng)絡(luò)“重現(xiàn)”智慧。

- CF窗口化怎么設(shè)置?CF窗口化如何還原? 怎么變成全屏模式

- UWP應(yīng)用和普通應(yīng)用有什么區(qū)別? 怎么才能解決UWP跨平臺封裝難題

- Win7系統(tǒng)怎么更換軟件圖標(biāo)?更改為系統(tǒng)默認(rèn)圖標(biāo)的方法是什么

- 百度網(wǎng)盤下載慢怎么解決?如何利用免費提速的功能

- XP系統(tǒng)如何取消開機(jī)密碼 只需輸入舊開機(jī)密碼 接著新密碼欄留空即可取消

- 李誕淘寶直播開麥:首場累計銷售額達(dá)3200萬 新增粉絲58萬

- ssid是什么意思?ssid詳細(xì)介紹:就是路由器發(fā)送的無線信號之名

- MSN安裝不了怎么辦?如何解決?如果已經(jīng)安裝低版本軟件有可能造成沖突

- 《獵天使魔女:起源》容量大小曝光:僅有3.5GB-天天播報

- 修改保存hosts沒有管理員權(quán)限怎么辦?修改hosts提示沒有權(quán)限解決方法

- 智能穿戴設(shè)備當(dāng)落腳于提升服務(wù)質(zhì)量

- Win10由于找不到x3daudio1_7.dll是怎么回事?解決步驟來了

- 什么軟件可以一鍵重裝系統(tǒng) 如何升級享有全新系統(tǒng)服務(wù)

- 電腦開機(jī)提示“CMOS checksum error-Defaults loaded” 簡單原因分析

- win7無法找到系統(tǒng)管理員賬戶怎么辦?電腦怎么啟用Administrator賬戶

- 注意更新!微軟殺軟Defender漏洞可能永久刪除用戶文件

- steam錯誤代碼-103怎么解決?可以輸入全新的DNS服務(wù)器地址解決

- kiss病毒主要中毒癥狀表現(xiàn)有哪些?電腦中了kiss病毒的解決方法

- OPPO將在“2022未來科技大會”上發(fā)布首個健康概念產(chǎn)品

- 應(yīng)用程序啟動出現(xiàn)0xc0000142錯誤怎么辦?教你如何運行命令提示符解決

- 驅(qū)動精靈怎么安裝電腦攝像頭驅(qū)動 攝像頭不能正常使用的原因分析

- Win7電腦開機(jī)一直轉(zhuǎn)圈進(jìn)不去系統(tǒng)怎么辦?可勾選“隱藏所有Windows服務(wù)”再重啟電腦

- 電腦怎么設(shè)置定時關(guān)閉程序?定時關(guān)閉某軟件的方法發(fā)布

- 電腦出現(xiàn)file not found什么意思?中文即為文件未找到之意

- 自媒體人還能在知乎上賺到錢嗎?

- 河北茍各莊:位于河北省淶水縣野三坡百里峽旅游風(fēng)景區(qū)

- 2010年世界杯總決賽 :在南非約翰內(nèi)斯堡舉行 西班牙進(jìn)入決賽

- 迅雷下載任務(wù)包含違規(guī)內(nèi)容無法繼續(xù)下載怎么辦?詳細(xì)的解決方法來了

- 步步高s7參數(shù)配置 步步高s7it怎么升級 更新前的準(zhǔn)備工作是什么

- LG shine系列手機(jī)怎么樣 都有哪些款式型號

- 三星電腦手機(jī)互聯(lián) 如果系統(tǒng)提示手機(jī)無法連接 可嘗試重啟電腦

- dear friend.原唱是誰 這張專輯是由誰制作

- 推特將把字符數(shù)限制提高到4000 網(wǎng)友:越學(xué)越深入

- 蘋果11怎么查詢激活時間查詢 教你怎么查詢激活日期和保修日期

- 小米f碼是什么 誰會有小米f碼 如何找到f碼購買通道

- 流量礦石系統(tǒng)是什么 是一種眾包模式的云計算方案 可進(jìn)行最優(yōu)化的實時部署

- 電腦怎么設(shè)置禁止安裝程序軟件?禁止安裝程序軟件保護(hù)電腦安全方法

- ipad1越獄方法說明 快來學(xué)習(xí)怎么給ipad1平板越獄

- iPhone4的價格 iphone4代各版本報價全面匯總

- 迅雷經(jīng)常崩潰 可能是注冊表被破壞 建議卸載重裝

- 步步高i泡泡508怎么樣 主要定位是女性消費者 受年輕人喜愛

- 三星sghe848怎么樣 支持LivingWorld動態(tài)主題功能 內(nèi)置播放器強(qiáng)大

- 2232gw怎么樣 和三星2232gw+手機(jī)有哪些不同

- 工人舍筆記本怎么樣 KOHJINSHA SA S18LC機(jī)身小巧 設(shè)計奇妙

- 諾基亞1030怎么樣 使用Windows 10智能操作系統(tǒng) 系統(tǒng)性能出色

- 工商銀行手機(jī)充值 工行支付寶企業(yè)版網(wǎng)銀充值說明

- 小米3多少錢?小米3價格:16GB版為1999元 64GB版2499元

- vodafone手機(jī)介紹 與Xperia高端智能手機(jī)品牌有何聯(lián)系

- 東皇太一什么時候出現(xiàn)的 東皇太乙使用技巧詳細(xì)講解

- 便攜式wlan熱點是什么 如何設(shè)置 便攜式wlan熱點需要注意的事項講解

- 諾基亞n86多少錢及產(chǎn)品介紹 報價為1330元 外觀既時尚又好看

- 金士頓8g優(yōu)盤多少錢 金士頓8g優(yōu)盤參數(shù)介紹 DTLPG3 8g優(yōu)盤屬于加密U盤 報價99元

- 索愛k550c評測與報價 不僅擁有強(qiáng)大的影音娛樂功能 外觀更驚艷

- 空調(diào)為什么不能制熱:室外溫度過低會造成空調(diào)無法正常工作

- 聯(lián)想旭日125f拆機(jī)教程 卸掉背后能卸的一切部件為第一步

- lg冰淇淋二代手機(jī)測評 擁有華麗的燈光效果 鍵盤功能鍵可在多項任務(wù)之間切換

- 漫步者m35怎么使用 支持三種信號輸入方式 能夠配合多種輸入設(shè)備使用

- 國產(chǎn)平板電腦哪個牌子好 藍(lán)魔產(chǎn)品性價比一流 一系列四核產(chǎn)品讓人目不暇接

- 免費無線上網(wǎng)接收器是什么 為什么它會和無線網(wǎng)卡性質(zhì)一樣

- 索尼lt18i如何刷機(jī)?本教程將介紹用recovery來刷ROM

- 網(wǎng)絡(luò)交換機(jī)維修方法 如何對cpld驅(qū)動器進(jìn)行檢查 怎么更換內(nèi)存條

- win10電腦怎么禁用smartscreen篩選器檢測功能?smartscreen篩選器禁用方法

- AMDhd8570顯卡怎么樣 AMDhd8570顯卡評測 顯存類型屬于GDDR5 定位屬于中高端

- 三星u100評測介紹 采用一體式鍵盤 但長輸入時容易造成誤操作

- 華為U8825d如何刷機(jī) 華為U8825d刷機(jī)方法介紹 怎么為電腦裝上手機(jī)驅(qū)動

- 設(shè)置權(quán)限的qq空間怎么進(jìn)去 教你如何破解相關(guān)的權(quán)限

- iphone怎么設(shè)置充電提示音 具體的操作方法說明

- 空調(diào)泵哪個牌子好 肯富來牌空調(diào)泵在世界享有盛名

- Steam周銷榜:Steam Deck四連冠 迎半價《賽博朋克2077》上榜-當(dāng)前速遞

- win10提示文件包含病毒或潛在垃圾無法成功完成操作解決辦法?

- 一體機(jī)電腦什么牌子好 聯(lián)想一體機(jī)性能取勝 具備專業(yè)化流水線作業(yè)

- 電腦啟動不了怎么辦 教你如何解決 散熱不良導(dǎo)致的開機(jī)問題該如何解決

- 分區(qū)表丟失如何修復(fù) 分區(qū)表丟失恢復(fù)方法 修復(fù)工具準(zhǔn)備都有什么 如何搜索分區(qū)

- 未來PS獨占游戲盤點:《死亡擱淺2》《最終幻想7:重生》等

- 華為Mate40E和Mate40有什么區(qū)別 全方位的對比分析上線

- jpg文件怎么打開?jpg是什么格式?是圖片文件的一種 較為通用

- 小米13 Pro發(fā)布:金屬邊框 比iPhone 14 Pro好看!

- 感染勒索病毒后怎么通過DiskGenius恢復(fù)數(shù)據(jù)?電腦恢復(fù)誤刪數(shù)據(jù)操作

- 天貓和淘寶有什么區(qū)別 淘寶網(wǎng)店鋪開設(shè)條件是什么

- OPPOA93s和OPPOA93的區(qū)別是什么 前者搭載天璣700處理器 后者采用驍龍480

- 每日低價硬貨:12代酷睿國產(chǎn)迷你主機(jī)僅需1799元

- SSI是什么 通常稱為服務(wù)器端嵌入 是類似ASP的網(wǎng)頁制作技術(shù)

- 電腦開機(jī)密碼怎么設(shè)置 windows 7系統(tǒng)電腦開機(jī)密碼設(shè)置方法是什么

- 云安全是什么意思:實為瑞星公司提出 和云計算沒有任何關(guān)系

- 史上最簡單清理最干凈工具大全 小提示:可直接刪除休眠文件hiberfil.sys

- 大金剛白菜價 4K 144Hz顯示器僅1999元-全球關(guān)注

- 微信終于修復(fù)!轉(zhuǎn)發(fā)文件多次保存問題解決:不占空間了

- 天涯明月刀捏臉數(shù)據(jù)怎么導(dǎo)入 天涯明月刀捏臉數(shù)據(jù)導(dǎo)入導(dǎo)出流程來了

- 逼死入門獨顯 英特爾14代酷睿核顯性能飛升-世界通訊

- 有198開頭的手機(jī)號嗎?屬于什么類型的卡?該電話號段在什么時候上線

- tks是什么意思 在電腦中代表程序的配置文件 可用UltraEdit-32打開

- 手機(jī)號被限制是什么意思 手機(jī)號被限制的原因介紹

- win7家庭普通版和旗艦版有什么區(qū)別 在視覺效果上的不同都有哪些

- 飛利浦吸塵器fc8202專用工具 采用全紙質(zhì)包裝 全面符合環(huán)保理念

- 小米13發(fā)布:還是3999沒漲價 12+512GB還便宜200

- cpu k kf f的區(qū)別 英特爾不同CPU型號產(chǎn)品解析

- 2022賀歲檔總票房突破4億!《阿凡達(dá)2》勢不可擋 最快破億

- 害怕發(fā)燒?美國一男子的血液可以殺死新冠-環(huán)球熱點評

- 電腦中了mssecsvc.exe病毒該怎么消除?mssecsvc.exe病毒查殺方法

- rar密碼怎么破解 rar密碼破解教程 這樣做就不怕忘記rar解壓密碼

新聞排行

精彩推薦

超前放送

- Win10系統(tǒng)產(chǎn)品密鑰怎么刪除?win...

- uos下安裝輸入法詳細(xì)操作方法 L...

- 戴爾筆記本和聯(lián)想筆記本哪個好?...

- 什么是單頭電熱管?全面分析單頭...

- 電腦使用360之后圖標(biāo)全部顯示空...

- 麥克風(fēng)在Microsoft Teams不能正...

- 光盤鏡像文件是什么格式 為什么...

- 網(wǎng)絡(luò)機(jī)頂盒什么牌子好 泰捷webo...

- 手機(jī)酷狗怎么剪切歌曲?這幾步就...

- 新飛洗衣機(jī)怎么樣 研發(fā)世界領(lǐng)先...

- 蘋果4s手機(jī)殼多少錢 MeieaS魅士...

- 同步助手怎么修復(fù)使用iPhone時的...

- 中國藍(lán)TV在線觀看和離線下載中國...

- 在MicrosoftTeams中的會議中共享...

- 諾基亞手機(jī)圖片大全及報價 Lumi...

- 戴爾1420筆記本怎么拆卸與安裝鍵...

- 招行小招卡如何激活 如多次自動...

- Word文檔圖片打印不出來解決方法...

- 用微信怎么查詢手機(jī)話費和流量的...

- 松下高速掃描儀熱門型號和價格介...

- OneNote打不開0x80070005怎么辦...

- 寶捷訊手機(jī)大全及最新報價 寶捷...

- 陌陌現(xiàn)場是什么意思?是陌陌官方...

- Adobe錯誤代碼和解決方法分享 A...

- 新小米盒子怎么樣?使用Cortex-A...

- 12306網(wǎng)上退火車票怎么退?可以...

- 筆記本電腦殺毒方法介紹 建議如...

- 樂視體育app怎么使用簡版列表模...

- 網(wǎng)購手機(jī)好不好 明面上配置高暗...

- AlphaGo是什么 谷歌AlphaGo詳細(xì)...

- Steam購買游戲支付時黑屏了怎么...

- 2020年520心形紀(jì)念幣怎么購買 ...

- 12306購票時間幾點到幾點 系統(tǒng)...

- 12308怎么訂汽車訂票?這個教程...

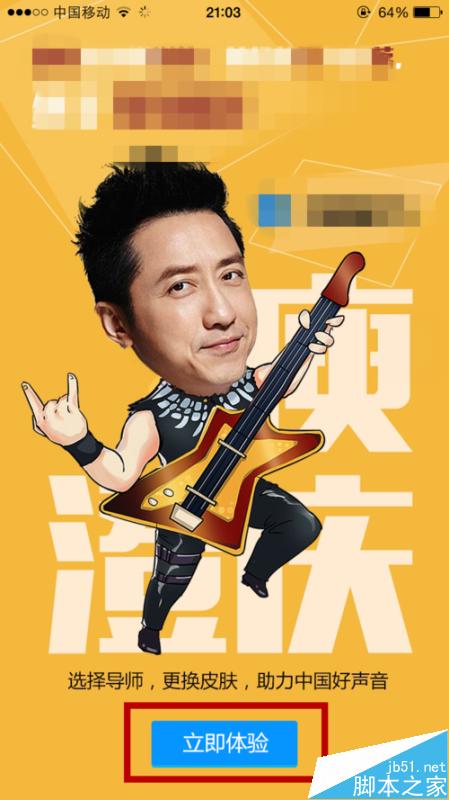

- 蘋果版微信怎么換圖標(biāo)?iPhone手...

- 啟動攝像頭黑屏問題解決方法分析...

- 電影大贏家完整版怎么免費看? ...

- 搜蘋果PC安裝器使用教程來了 相...

- 愛奇藝如何查看播放記錄?不知道...

- 支付寶app怎么加入信用生活圈和...

- 釘釘如何設(shè)置禁言?手機(jī)釘釘設(shè)置...

- win10修改微軟拼音輸入法的方法...

- 手機(jī)淘寶怎么綁定支付寶 在電腦...

- 微軟數(shù)據(jù)恢復(fù)工具Windows File...

- CAROLINA HERRERA 2023早秋系列

- 煥新穿搭靈感,冬季氣場全開

- 怎么徹底從Windows中卸載Flash?...

- office提示安裝程序包的語言不受...

- 小米1TB移動固態(tài)硬盤發(fā)布:眾籌6...

- 一夜之間,大家都在問,金晨是不...